性别会影响医疗资源公平分配?临床算法中是否要包含性别?《新英格兰医学杂志》发表的审查框架可帮助评估!

时间:2025-02-09 12:11:06 热度:37.1℃ 作者:网络

临床医生在做决策时,除了依靠自身的专业判断,还会借助一个“智能助手”——临床算法。这些算法基于大量的患者数据,通过统计分析或机器学习等方法开发而成,它能根据患者的各种信息来预测病情、评估风险,帮助医生决定是否给患者某种治疗、是否让患者接受某种检查等。例如,肺功能估计会影响肺癌患者的手术建议,静脉血栓栓塞风险计算器会影响放射影像学检查的决策。此外,算法还会影响医疗资源分配。许多美国医疗指南使用算法预测来评估患者获得医疗资源的资格,如器官移植、供应受限的治疗和癌症筛查等。可见临床算法对患者护理有着深远的影响。因此确保算法准确、无偏见和公平是临床和伦理责任,也是法律义务,特别是当算法的变量中包含“种族”、“性别”这种受保护特征时。

近年来,为追求公平,许多医疗组织已修订算法以排除“种族”变量。然而,对于“性别”这一同样常见的受保护特征,医学界却相对沉默。性别与临床结果之间的关联可能源于生物学,也可能由有偏见的护理模式造成,因此,一概而论地从临床算法中排除性别在临床上是不合理的,必须有一个深思熟虑的过程来决定性别因素是包含还是排除。

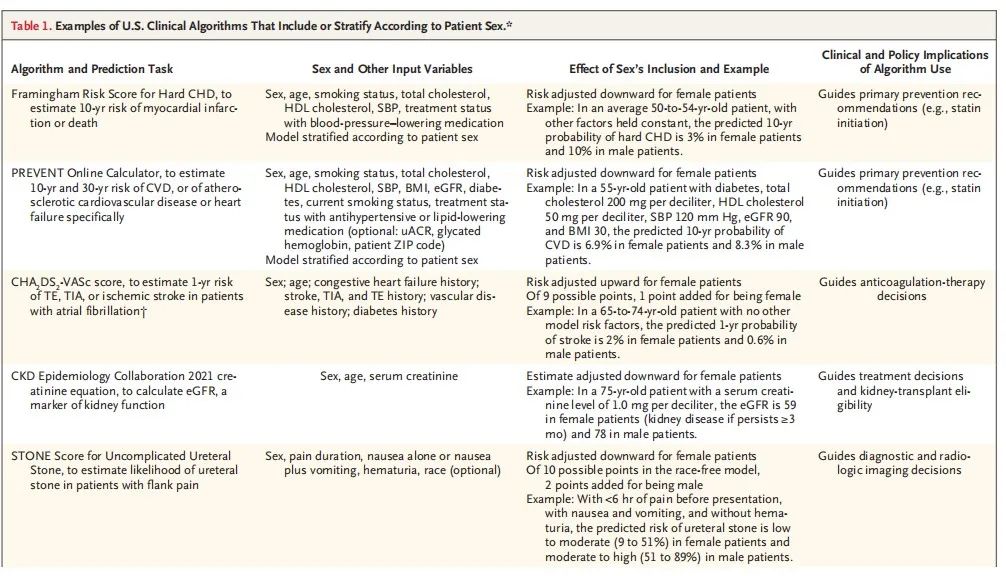

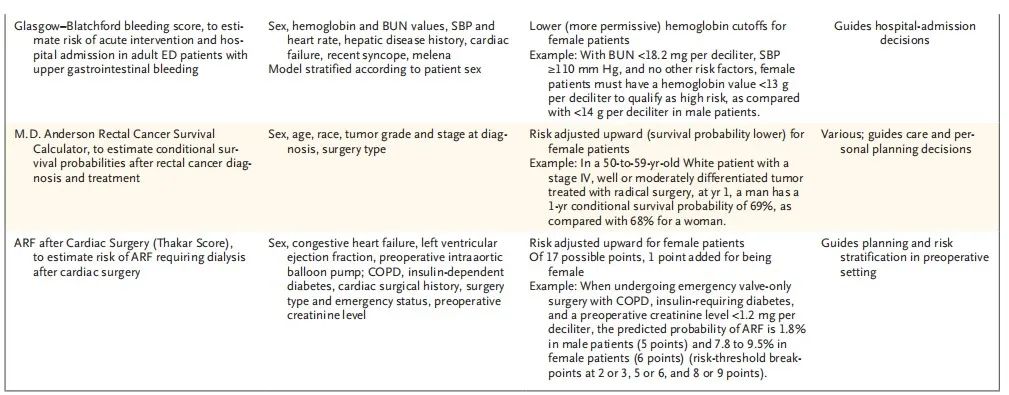

许多常用的临床算法包含或根据患者性别进行分层(见表1)。对于在所有纳入属性上都相同、仅性别不同的患者,这些算法的预测结果会有所不同。相应地,依赖这些预测结果的医疗决策或医疗资格认定对于其他方面相似的男性和女性患者也可能有所不同。这种差异化对待是包含性别因素的临床算法使用与反歧视法律保护之间潜在冲突的交汇点。

表1 根据患者性别包含或分层的美国临床算法示例

为了帮助算法开发者和临床医生评估在算法中包含性别的合理性。研究团队开发了一个在临床、法律和伦理方面都有所依据的框架:性别算法纳入审查框架(FAIRS),并将研究成果发表于《新英格兰医学杂志》(The New England Journal of Medicine ),文章题为“FAIRS—A Framework for Evaluating the Inclusion of Sex in Clinical Algorithms”,其深入探讨了临床算法中性别因素的纳入问题,并提出了一个评估框架FAIRS。那FAIRS框架具体包含哪些问题?它又是如何平衡性别因素和患者利益的呢?

方法

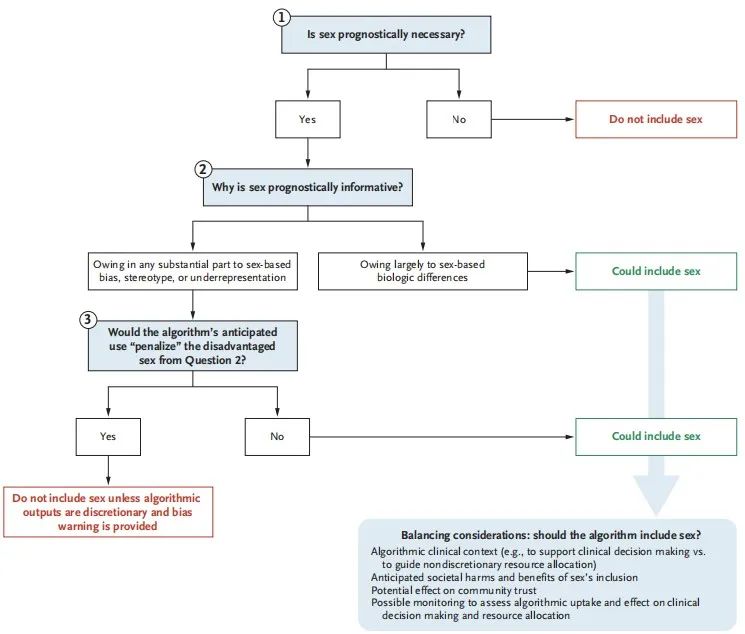

文章提出了一个名为FAIRS(Framework for Algorithm Inclusion Review for Sex)的框架,用于评估在临床算法中的纳入性别是否合适。FAIRS框架包含三个分支逻辑问题,这些问题涉及性别是否对预测结果具有预测必要性;性别与结果的关联是否主要是由生物学差异、偏见、刻板印象或研究中的代表性不足引起的;以及算法的预期使用是否会“惩罚”处于不利地位的性别,见图1。

图1 评价在临床算法中纳入性别的公平框架

文章通过FAIRS框架分析了两个具体的临床算法案例,这两个案例展示了在不同情境下,性别纳入算法可能带来的不同影响,以及如何根据FAIRS框架进行评估。

案例1:心脏骤停后脑死亡评分(Brain Death after Cardiac Arrest Score)

算法描述:该评分系统用于预测心脏骤停后患者脑死亡的风险。

性别纳入情况:在该算法中,性别作为一个变量被纳入,以预测脑死亡的风险。

FAIRS框架评估:

问题1:性别是否具有预测必要性?

研究发现,性别在该算法中具有预测必要性,因为去除性别变量会降低算法的预测性能。

问题2:性别为何具有预测信息?

分析表明,性别与脑死亡风险的关联主要由生物学差异解释,例如男性和女性在生理结构和激素水平上的差异可能影响脑死亡的风险。

问题3:算法的预期使用是否会“惩罚”处于不利地位的性别?

该算法主要用于识别高风险患者,以便进行更积极的监测和干预。在这种情况下,性别纳入算法并不会对女性患者造成不利影响,反而可能有助于资源和关注向女性患者倾斜,以弥补性别差异带来的风险。

案例2:无症状成人晚期结直肠肿瘤风险分层评分系统(Scoring System to Stratify the Risk of Advanced Colorectal Neoplasia in Asymptomatic Adults)

算法描述:该评分系统用于评估无症状成人晚期结直肠肿瘤的风险。

性别纳入情况:该算法中也纳入了性别作为变量,以预测结直肠肿瘤的风险。

FAIRS框架评估:

问题1:性别是否具有预测必要性?

研究发现,性别在该算法中同样具有预测必要性,去除性别变量会显著降低算法的预测准确性。

问题2:性别为何具有预测信息?

分析显示,性别与结直肠肿瘤风险的关联部分由生物学差异解释,但也有证据表明,医疗保健中的性别偏见和历史代表性不足可能对这种关联有显著贡献。例如,女性在结直肠肿瘤的诊断和治疗中可能被低估和忽视。

问题3:算法的预期使用是否会“惩罚”处于不利地位的性别?

该算法的预期使用是识别高风险患者进行早期筛查和干预。如果算法用于强制性决策(如保险报销),则纳入性别可能会对女性患者造成不利影响,因为她们可能会因为预测的高风险而被拒绝保险或获得较少的医疗资源。然而,如果算法用于指导临床决策,促进对高风险患者的更积极监测和干预,则性别纳入算法可能是适当的,因为它有助于识别和弥补性别差异带来的风险。

通过FAIRS框架对这两个案例的分析,文章展示了如何在不同情境下评估性别在临床算法中的纳入是否合适。在第一个案例中,性别纳入算法是基于生物学差异,并且用于识别高风险患者,因此被认为是适当的。在第二个案例中,虽然性别也具有预测必要性,但由于性别与结果的关联部分由偏见和代表性不足引起,因此需要进一步评估算法的预期使用是否会“惩罚”处于不利地位的性别。这表明,性别在临床算法中的纳入是否合适取决于多种因素,包括生物学差异、偏见、算法的预期使用和潜在的社会影响。通过这种详细的评估,FAIRS框架提供了一种系统的方法来平衡临床需求、伦理考虑和法律义务。

FAIRS框架是一个初步的框架,研究者的目的是激发对这一重要话题的讨论。文章强调,简单地从临床算法中移除性别可能会损害患者利益,并可能只是将偏见隐藏起来,导致表面上看似性别中立的算法实际上对男性和女性患者的表现不同。研究者呼吁专业学会关注性别在临床算法中的作用,并鼓励临床社区开始处理这个问题,以避免潜在的伤害,并使法院和监管机构在定义合法的差异化护理和非法歧视之间的界限时能够考虑这些标准。FAIRS框架提供了一个基于临床、法律和伦理的评估方法,但作者也承认其局限性,并欢迎各位研究者进一步的研究和合作。

参考资料:

[1]Goodman KE, Blumenthal-Barby J, Redberg RF, Hoffmann DE. FAIRS - A Framework for Evaluating the Inclusion of Sex in Clinical Algorithms. N Engl J Med. 2025 Jan 23;392(4):404-411. doi: 10.1056/NEJMms2411331. Epub 2025 Jan 8. PMID: 39778166.